다중 모드 학습 분야에서 시각 언어 모델(VLM)의 급속한 발전은 다양한 모드를 통합하는 데 큰 잠재력이 있음을 보여주었습니다. 그러나 상당한 진전에도 불구하고 이러한 모델은 주로 짧은 텍스트 작업에 초점을 맞추고 있으며, 긴 텍스트를 이해하는 능력이 항상 약점이었습니다. 특히 긴 영상 이해와 고해상도 이미지/영상 이해를 다룰 때, 확장된 시각적 맥락을 효과적으로 처리하는 방법은 여전히 어려운 문제로 남아 있습니다.

긴 텍스트를 이해하는 데 있어서의 딜레마와 과제

긴 텍스트를 이해하는 데 부족한 점은 기존 시각 언어 모델이 데이터 세트 구축, 아키텍처 설계, 학습 전략, 컴퓨팅/메모리 병목 현상 등 많은 어려움에 직면하고 있기 때문입니다. 이전 연구에서는 컨텍스트 길이를 늘리려고 시도했지만, 그 결과는 이상적이지 않았습니다. 독점 모델과 비교했을 때 성능 개선이 제한적이었습니다. 시각적 입력이 증가함에 따라 개선이 일관되지 않습니다. 최적의 훈련 전략은 아직 명확하지 않습니다.

Eagle 2.5: 장문 텍스트 학습의 판도를 바꾸는 제품

이러한 배경에서 엔비디아가 출시한 Eagle 2.5 모델은 빛나는 새 별과 같으며, 장문 텍스트 비전 언어 모델 개발에 새로운 희망을 가져다줍니다. 단순히 긴 멀티모달 시퀀스를 처리하기 위해 성능을 희생하는 모델과 달리, Eagle 2.5는 단순히 긴 입력을 수용하는 것이 아니라 입력 길이가 늘어나도 일관된 성능 향상을 달성합니다. 컨텍스트 커버리지 측면에서 좋은 성능을 보이며, 프레임 수가 증가함에 따라 성능이 지속적으로 상승하는 추세를 보입니다. GPT-4o 및 Qwen2.5-VL-72B와 같이 매개변수가 더 큰 모델과 비교했을 때 Eagle 2.5는 더 작은 매개변수 크기를 유지하면서도 성능이 동일하게 우수합니다.

이미지 및 비디오 이해의 우수성

Eagle 2.5는 이미지 및 비디오 이해를 위한 여러 벤치마크에서 뛰어난 성능을 입증했으며, 오픈 소스 및 독점 모델과 비교했을 때 매우 경쟁력 있는 결과를 달성했습니다. 비디오 이해 측면에서 Eagle2.5-8B는 여러 비디오 벤치마크에서 인상적인 결과를 달성했습니다. MVBench에서 74.8점, Perception_test에서 82.0점, EgoSchema에서 72.2점을 기록하며 비슷한 크기의 InternVL2.5-8B(72.0)와 Qwen2.5-VL-8B(69.6, 70.5, 65.0)를 쉽게 앞질렀습니다. 긴 영상 이해 측면에서 Eagle 2.5는 더욱 뛰어난 성과를 보였으며, MLVU에서는 77.6점, LongVideobench에서는 66.4점을 기록하며 InternVL2.5-78B(75.7점, 63.6점)를 앞지르기도 했습니다. VideoMME(자막 없음)에서 Eagle 2.5는 72.4를 달성했습니다. 이는 72B 매개변수 모델과 매우 비슷하지만 훨씬 적은 매개변수를 사용합니다.

이미지 이해 측면에서도 Eagle2.5-8B는 문서 이해(DocVQA에서 94.1점, ChartQA에서 87.5점), 정보 추출(InfoVQA에서 80.4점, TextVQA에서 83.7점), 광학 문자 인식(OCRBench에서 869점) 등 여러 분야를 포괄하여 좋은 성과를 보였습니다. 또한 이 모델은 일반적인 지각 및 추론 과제(MMstar에서 66.2, RWQA에서 76.7, MMB₁.₁에서 81.7), 도메인별 지식(MMMU에서 55.8, AI2D에서 84.5), 시각적 환각 평가(HallB에서 54.7), 수학적 추론(MathVista에서 67.8)에서도 균형 잡힌 역량을 보여주었습니다.

독특한 훈련 전략: 정보 우선 샘플링 및 점진적 훈련

Eagle 2.5의 뛰어난 성능은 주로 훈련 전략 덕분입니다. 이 전략은 정보 우선 샘플링과 점진적 훈련이라는 두 가지 핵심 요소로 구성됩니다.

정보 우선 샘플링

다중 모드 훈련에서는 시각적 콘텐츠 샘플링이 매우 중요합니다. 여러 이미지로 구성된 문서에는 초고해상도 이미지가 수십 페이지에 걸쳐 포함되는 경우가 많고, 비디오 콘텐츠는 몇 초에서 몇 시간 길이까지 다양합니다. 이러한 다양성을 효과적으로 관리하기 위해 Eagle 2.5는 시각적, 의미적 차원 모두에서 정보 보존을 촉진하는 정보 우선 샘플링 전략을 제안합니다.

- 이미지 영역 보호(IAP) : 기존 타일링 방법은 W × H 크기의 이미지를 고정된 그리드로 나눕니다. 이 방법은 고해상도 입력에는 효과적이지만, 부적절한 종횡비 처리로 인해 원본 이미지의 기하학적 형태가 왜곡되는 경우가 많습니다. 이 문제를 해결하기 위해 Eagle 2.5는 면적 보존과 종횡비 충실도라는 두 가지 핵심 목표를 최적화하는 면적 우선 타일링 전략을 제안합니다.

- 자동 다운샘플링(ADS) : 시각-언어 모델은 시각적 입력과 텍스트 입력 간의 시퀀스 길이 예산을 신중하게 분배해야 합니다. Eagle 2.5는 이러한 균형을 동적으로 최적화하는 전체 컨텍스트 중심 전략인 ADS(자동 다운샘플링)를 제안합니다. ADS는 2단계 저하 프로세스를 사용합니다. 시간 저하가 먼저 프레임이나 페이지의 샘플링을 최적화하고, 그 다음 타일 저하가 사용 가능한 컨텍스트의 활용을 극대화합니다.

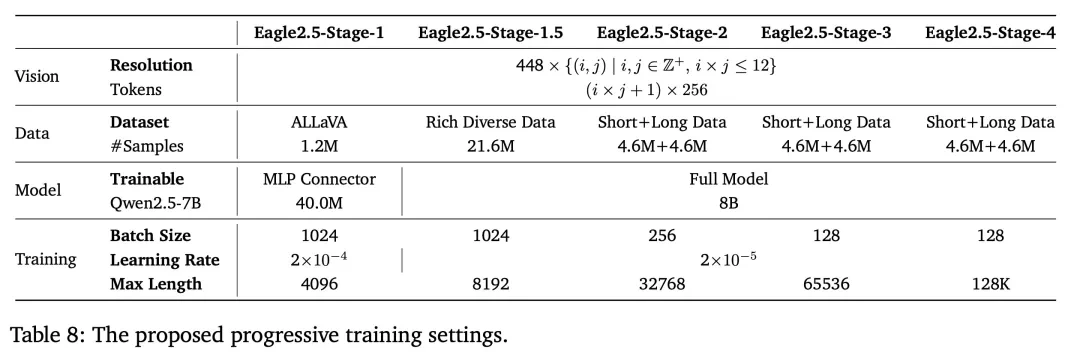

점진적 훈련

Eagle 2.5는 또한 두 가지 보완적인 전략으로 구성된 포괄적인 사후 훈련 프레임워크를 도입합니다.

- 믹싱 후 학습 : ADS 방식은 최대 시퀀스 길이에 따라 각 학습 샘플을 적응적으로 조정하여 프레임에 독립적인 학습 패러다임을 제공합니다. 하이브리드 학습 전략과 길이 균형 패킹을 구현함으로써 Eagle 2.5는 전체 컨텍스트 길이 범위에서 균일하게 성능을 최적화할 수 있습니다.

- 점진적 하이브리드 사후 학습 : 최대 시퀀스 길이 값이 더 큰 시나리오의 경우, Eagle 2.5는 모델을 점점 더 긴 시퀀스 길이에 점진적으로 노출시켜 확장된 컨텍스트를 처리하는 능력을 체계적으로 향상시키는 점진적 하이브리드 학습 방법을 제안합니다.

Eagle-Video-110K: 긴 텍스트 이해를 위해 맞춤화된 다양한 비디오 데이터 세트

기존 비디오 데이터 세트에는 포괄적으로 긴 텍스트를 이해하는 데 필요한 내용을 충족하기에는 너무 짧은 비디오가 포함되어 있는 경우가 많습니다. Eagle-Video-110K는 Vidchapters, MiraData, InternVid-10M, Panda-70M, Vript, Shot2story, ViTT, WebVid-10M 등 다양한 소스에서 긴 비디오 컬렉션을 큐레이팅하여 이러한 제한을 해결합니다. Eagle-Video-110K는 CLIP 임베딩과 유사성 임계값을 기반으로 다양성 중심 전략을 채택하여 학습 및 평가에 사용할 수 있는 평균 기간을 크게 늘리는 새로운 비디오를 식별하고 선택할 수 있습니다.

Eagle-Video-110K의 또 다른 특징은 포괄적인 비디오 이해를 달성하기 위해 상향식과 하향식 접근 방식을 결합한 고유한 이중 주석 파이프라인입니다. 상향식 접근 방식에서는 인간이 주석을 단 챕터를 의미적으로 의미 있는 비디오 세그먼트로 활용하여 GPT-4o를 통해 챕터 수준의 고밀도 캡션과 긴 형식의 질문-답변 쌍을 생성합니다. 한편, 하향식 접근 방식은 로컬 시공간적 세부 정보에 초점을 맞춰 GPT-4o를 통해 시간 간격 참조와 텍스트 맥락 앵커가 포함된 클립 수준의 질문-답변 쌍을 생성합니다. 이러한 계층적 접근 방식을 통해 모델은 세밀한 시공간적 이해와 고수준의 의미적 이해를 모두 달성할 수 있어 긴 텍스트 비디오에 대한 추론에 강력한 지원을 제공합니다.

Eagle-Video-110K는 비디오 이해 성능에 상당한 영향을 미칩니다. 이 솔루션은 일반적인 긴 비디오와 짧은 비디오 벤치마크에서 모델 성능을 향상시킬 뿐만 아니라, 이전에 오픈 소스 학습 세트에서 누락되었던 더 긴 비디오 학습 데이터를 제공함으로써 높은 프레임 속도(≥128프레임)를 처리하는 모델의 능력을 크게 향상시킵니다. 이러한 개선은 특히 Video-MME 벤치마크에서 두드러지게 나타납니다. Eagle 2.5는 Eagle-Video-110K로 학습했을 때 프레임 수가 증가함에 따라 성능이 지속적으로 상승하는 추세를 보인 반면, 다른 모델은 정체되거나 심지어 성능이 저하되는 경향이 있습니다.

성능 및 벤치마크

Eagle 2.5-8B는 다양한 비디오 및 이미지 이해 작업에서 강력한 성능을 보여주었습니다. 비디오 벤치마크에서는 MVBench에서 74.8점, MLVU에서 77.6점, LongVideoBench에서 66.4점을 기록했습니다. 이미지 벤치마크에서 이 모델은 DocVQA에서 94.1점, ChartQA에서 87.5점, InfoVQA에서 80.4점을 기록했습니다.

절제 연구는 이글 샘플링 전략의 중요성을 보여줍니다. IAP를 제거하면 고해상도 벤치마크에서 성능이 저하되고, ADS를 생략하면 집중적인 감독이 필요한 작업의 효율성이 떨어집니다. 이 모델은 점진적인 학습을 통해서도 이점을 얻을 수 있습니다. 즉, 맥락의 길이를 점진적으로 늘리면 긴 텍스트 전체를 한꺼번에 학습하는 것보다 성능이 안정적으로 향상됩니다. 또한 Eagle-Video-110K를 추가하면 높은 프레임 속도(≥128프레임)에서 성능이 크게 향상되어 특수화된 장문 텍스트 데이터 세트의 가치가 더욱 부각됩니다.

결론

Eagle 2.5는 장문 텍스트 비전 언어 모델링에 대한 기술적으로 타당한 접근 방식을 제공합니다.

이 알고리즘은 맥락적 무결성, 점진적인 훈련 적응, 데이터 세트 다양성을 유지하는 데 중점을 두고 있으며, 이를 통해 아키텍처 일반성을 유지하면서도 강력한 성능을 달성할 수 있습니다. Eagle 2.5는 모델 확장에만 의존하는 것이 아니라, 신중하게 설계된 교육 전략과 데이터 설계를 통해 효율적이고 경쟁력 있는 복잡한 다중 모드 이해 시스템을 구축할 수 있음을 보여줍니다.

이를 통해 Eagle 2.5는 실제 멀티미디어 애플리케이션에 더 적합한 상황 인식 AI 시스템을 구축하는 데 있어 중요한 진전이 되었습니다.

'AI > Tool, 모델 소개' 카테고리의 다른 글

| MCP 프로토콜의 대대적인 업그레이드: Spring AI, Alibaba와 Higress, 업계 최초로 스트리밍 가능한 HTTP 구현 솔루션 출시 (1) | 2025.05.05 |

|---|---|

| 최고의 무료 AI 코딩 도구 7가지 (1) | 2025.04.28 |

| NVIDIA, DAM-3B 발표: 이미지와 비디오의 현지화된 설명 “스타일”! (0) | 2025.04.28 |

| Google ADK (Agent Development Kit) (3) | 2025.04.27 |

| 프롬프트 튜닝 (2) | 2025.04.22 |